Презентация на тему: Информация. Двоичное кодирование информации

Автор: Комкова Мария Сергеевна

Информация — это осознанные сведения об окружающем мире, которые являются объектом хранения, преобразования, передачи и использования.

Объективность информации. Объективный – существующий вне и независимо от человеческого сознания. Информация – это отражение внешнего объективного мира. Информация объективна, если она не зависит от методов ее фиксации, чьего-либо мнения, суждения.

Достоверность информации. Информация достоверна, если она отражает истинное положение дел. Объективная информация всегда достоверна, но достоверная информация может быть как объективной, так и субъективной.

Полнота информации. Информацию можно назвать полной, если ее достаточно для понимания и принятия решений. Неполная информация может привести к ошибочному выводу или решению. Точность информации определяется степенью ее близости к реальному состоянию объекта, процесса, явления и т. п.

Актуальность информации – важность для настоящего времени, злободневность, насущность. Только вовремя полученная информация может быть полезна. Полезность (ценность) информации. Полезность может быть оценена применительно к нуждам конкретных ее потребителей и оценивается по тем задачам, которые можно решить с ее помощью.

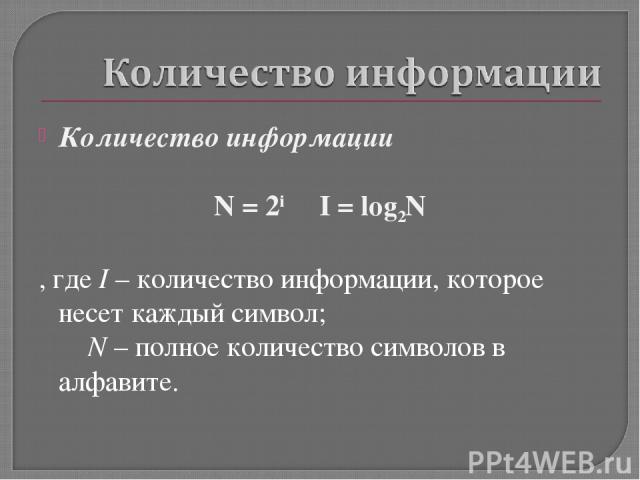

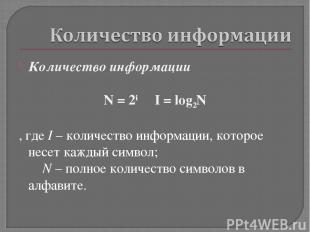

Количество информации N = 2i I = log2N , где I – количество информации, которое несет каждый символ; N – полное количество символов в алфавите.

За единицу количества информации принимается такое количество информации, которое содержится в информационном сообщении, уменьшающем неопределенность знания в два раза. Такая единица названа битом.

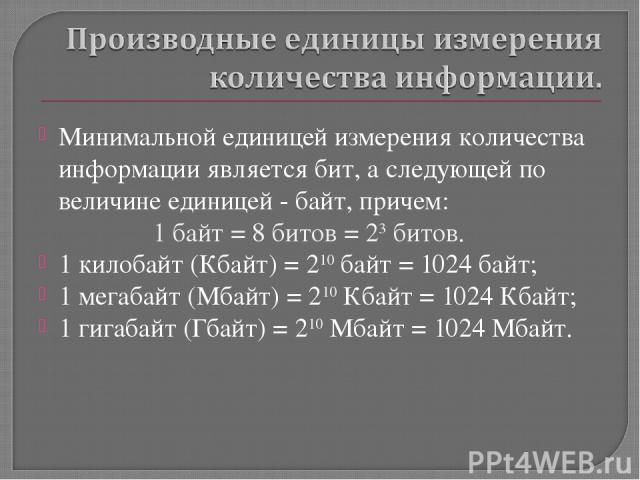

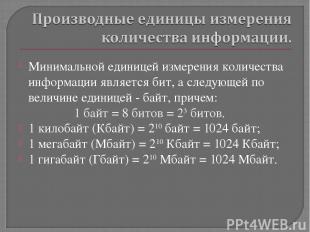

Минимальной единицей измерения количества информации является бит, а следующей по величине единицей - байт, причем: 1 байт = 8 битов = 23 битов. 1 килобайт (Кбайт) = 210 байт = 1024 байт; 1 мегабайт (Мбайт) = 210 Кбайт = 1024 Кбайт; 1 гигабайт (Гбайт) = 210 Мбайт = 1024 Мбайт.

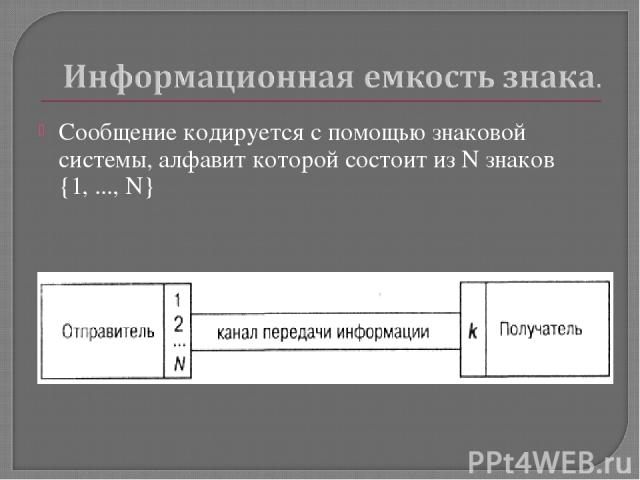

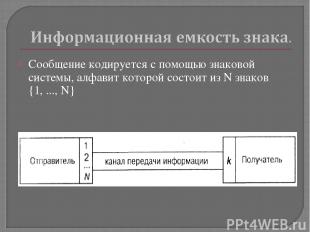

Сообщение кодируется с помощью знаковой системы, алфавит которой состоит из N знаков {1, ..., N}

Формула N = 2i связывает между собой количество возможных информационных сообщений N и количество информации I, которое несет полученное сообщение.

С помощью этой формулы можно, например, определить количество информации, которое несет знак в двоичной знаковой системе: N = 2 => 2 = 2I => 21 = 2I => I=1 бит Таким образом, в двоичной знаковой системе знак несет 1 бит информации.

С помощью формулы N = 2i определим количество информации, которое несет буква русского алфавита: N = 32 => 32 = 2I => 25 = 2I => I=5 битов. Таким образом, буква русского алфавита несет 5 битов информации (при алфавитном подходе к измерению количества информации).

Сообщение состоит из последовательности знаков, каждый из которых несет определенное количество информации.

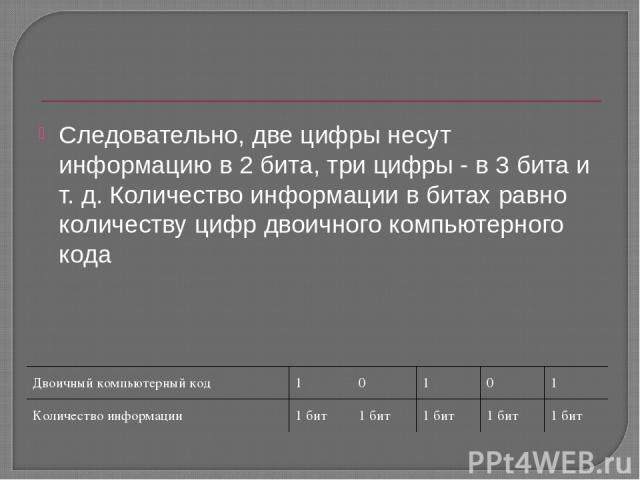

Если знаки несут одинаковое количество информации, то количество информации Ic в сообщении можно подсчитать, умножив количество информации Iз, которое несет один знак, на длину кода (количество знаков в сообщении) К: Ic = Iз × K Так, каждая цифра двоичного компьютерного кода несет информацию в 1 бит.

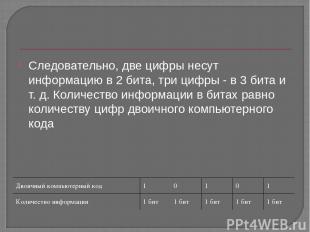

Следовательно, две цифры несут информацию в 2 бита, три цифры - в 3 бита и т. д. Количество информации в битах равно количеству цифр двоичного компьютерного кода Двоичный компьютерный код 1 0 1 0 1 Количество информации 1 бит 1 бит 1 бит 1 бит 1 бит